1.剑指最强AI芯片 AMD正式发布MI300系列

2.AMD官宣锐龙8040系列处理器 引领AI PC时代

3.AI ASIC芯片带动封测与载板需求,台厂打入供应链

4.绝地反击GPT-4,谷歌推出最强大模型Gemini

5.联电11月营收同比下降16.7%,Q4利用率预计为61%~63%

6.AMD预计今年AI芯片市场规模450亿美元,明年供应大增

1.剑指最强AI芯片 AMD正式发布MI300系列

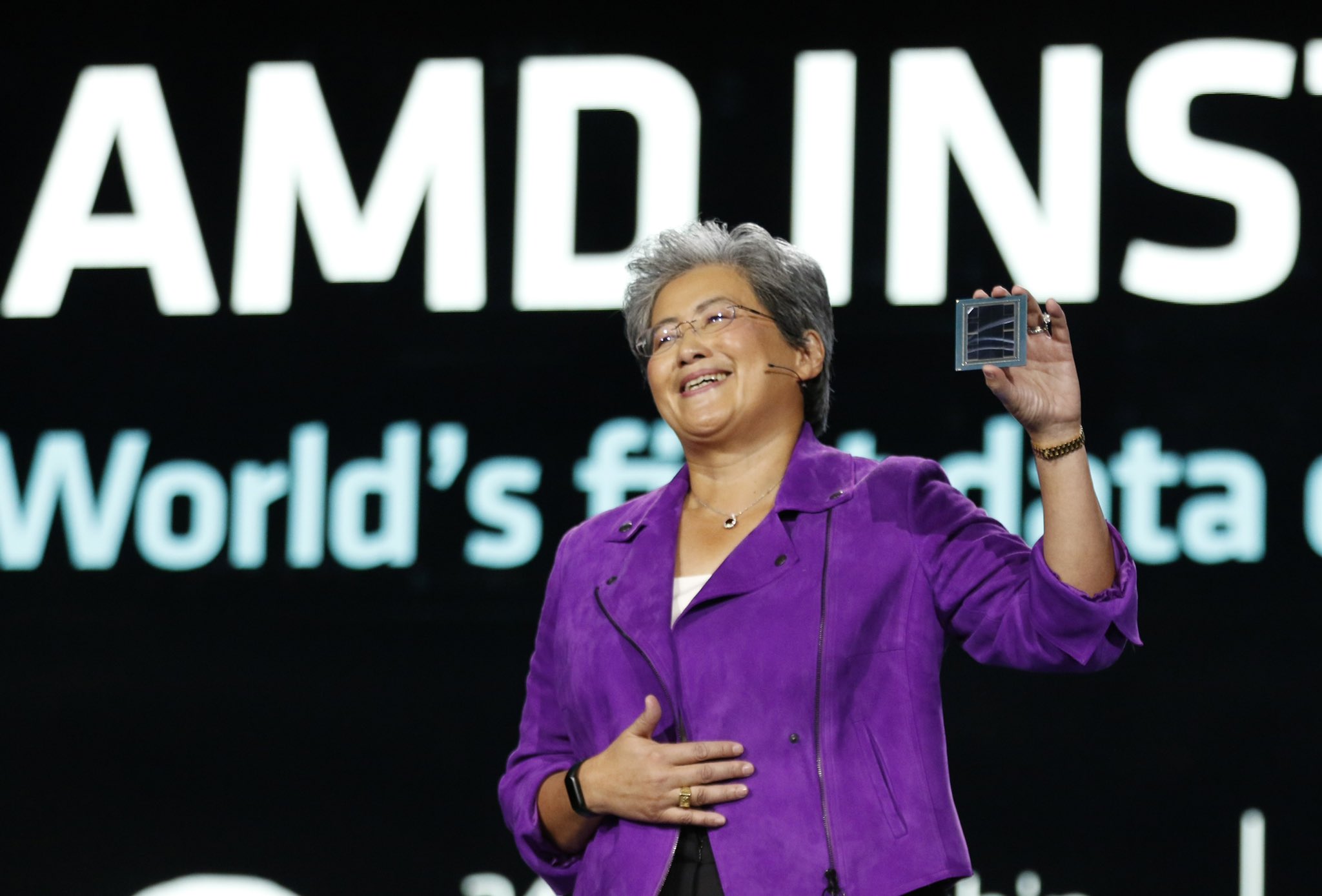

集微网报道 北京时间12月6日凌晨,AMD在美国加州城市圣何塞举行的“Advancing AI”活动上,正式发布MI300系列加速器产品。

AMD CEO苏姿丰表示,AI是过去50年最具变革性的技术,将有力推动在健康医疗、气候研究、AI助手、机器人、安全、内容创作等领域的创新。

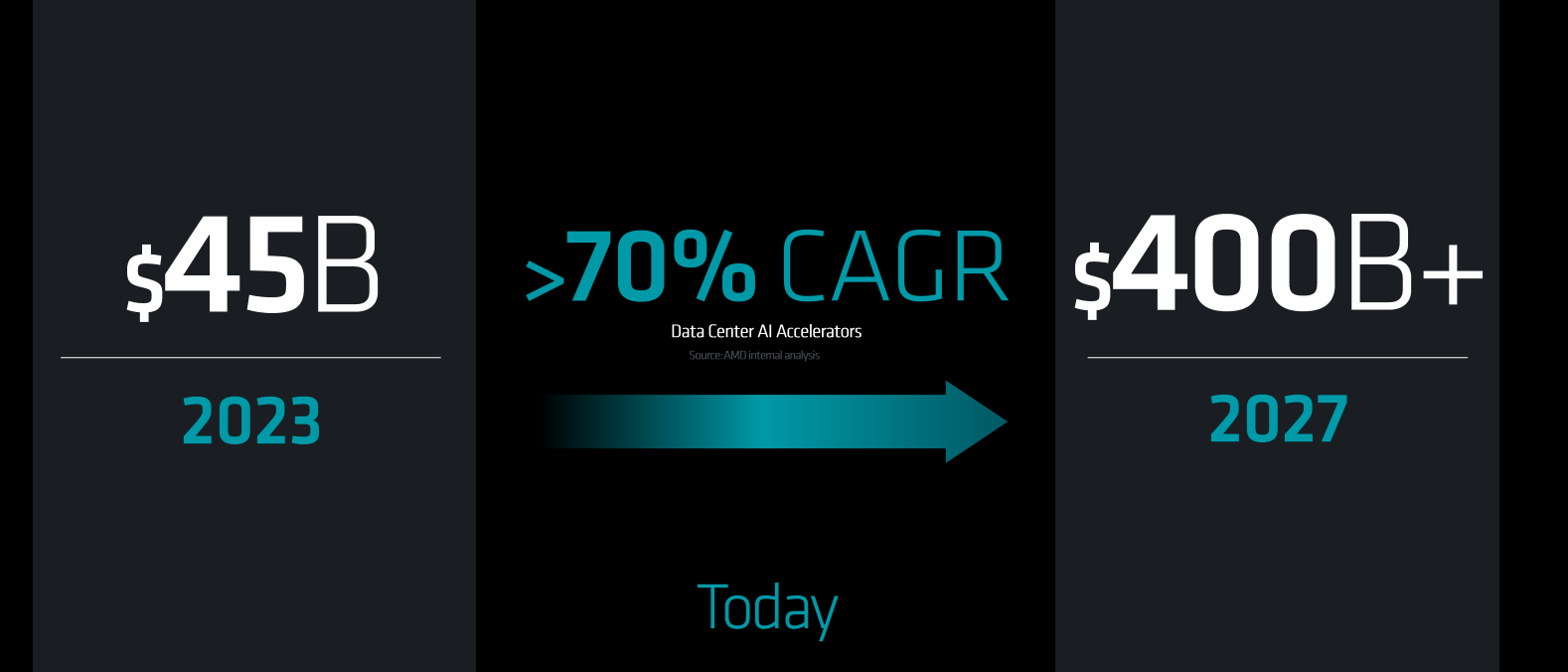

今年6月AMD在美国旧金山举办的“数据中心和人工智能技术首映式”活动上,苏姿丰曾强调,AI作为AMD第一战略重点,存在大量的市场机会,最大机遇来自数据中心。彼时AMD预计,来自CPU、GPU、FPGA以及其他AI数据中心业务将推动市场规模从2023年的300亿美元增加到2027年的1500亿美元,年均复合增长率超过50%。

而AI市场的成长着实飞速,在今天活动的现场,AMD修正了这一预判,即市场规模将从今年的450亿美元,增加到2023年的4000亿美元,年均复合增长率超过70%。

这样迅猛的发展态势,也使得几乎所有的科技企业无不投身于AI的浪潮之中。而凭借多年来在AI领域的深耕,AMD正在构建起从云、高性能计算、企业级、嵌入式以及PC等端到端的系统级AI基础设施解决方案优势。

具体而言,苏姿丰表示,AMD具有三方面优势,包括广泛的训练和推理相关的产品组合,开放的软件能力,以及多年来与AI生态系统建立起的深度合作基础。

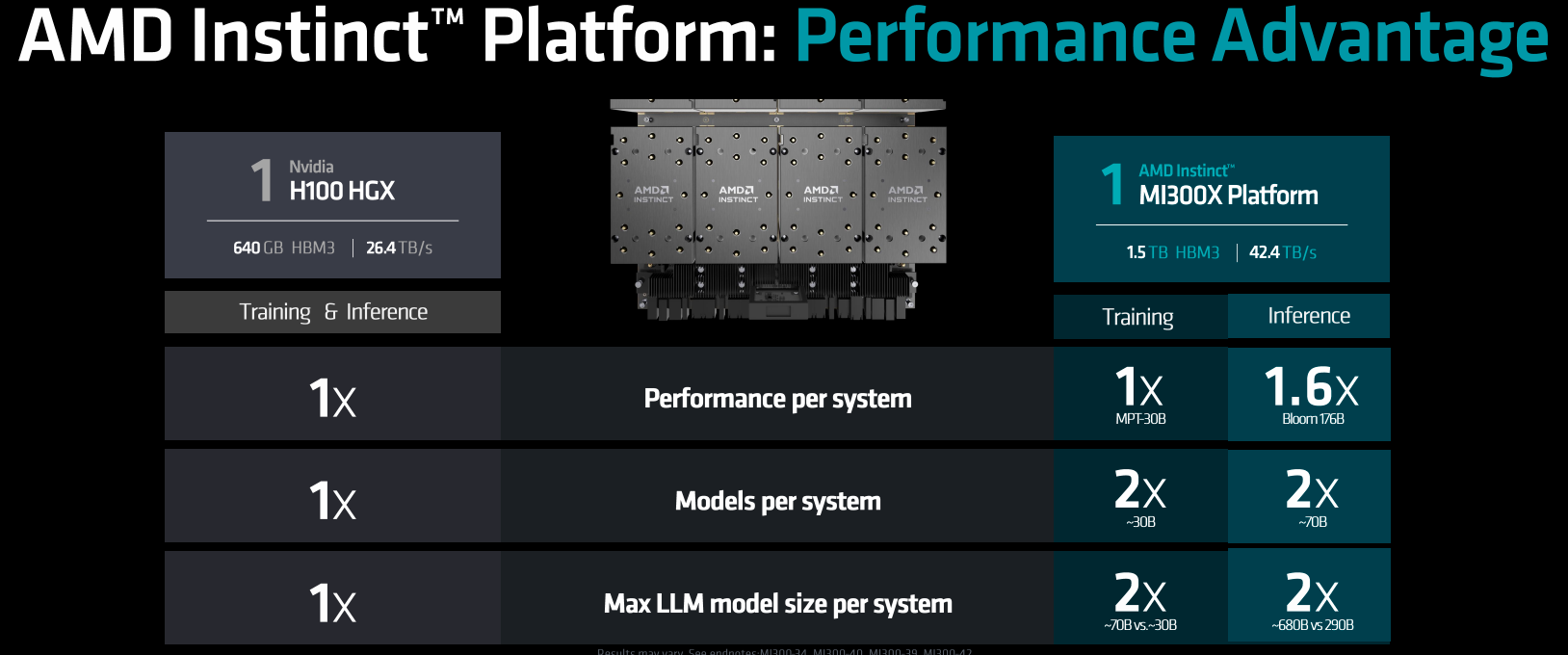

MI300X:为生成式AI而生,全面超越H100

自去年年底,生成式AI浪潮席卷全球,也显著推动了包括数据中心,智能终端等对于AI性能的需求。在此背景下,AMD推出的MI300X加速器适逢其时,而众多创新技术的加持下,也使得MI300X相比于上一代MI250X产品有了显著的提升。

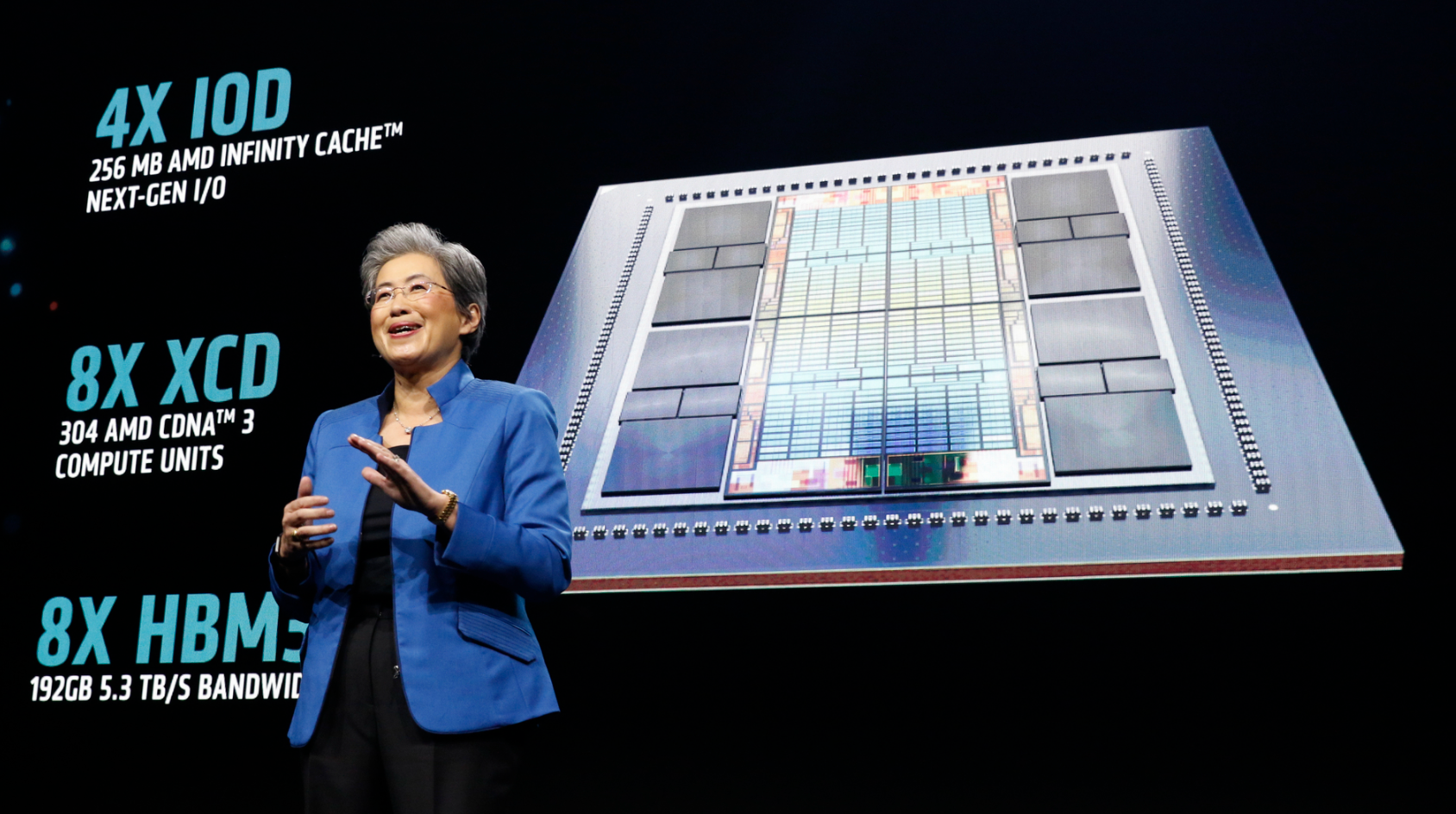

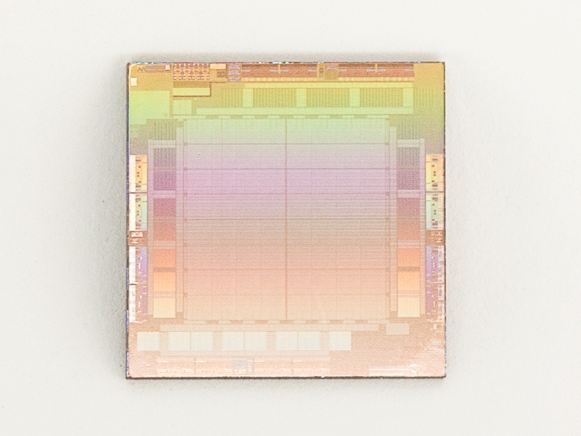

据介绍,MI300X采用了新一代的面向于AI计算的计算架构CDNA3,能够有效针对AI和HPC领域的负载需求,同时采用第四代AMD的Infinity互联技术架构的3D封装形式,从而实现对于性能以及功耗的进一步优化。

MI300X采用5nm制程,最多8个XCD核心,304组CDNA3架构的计算单元,8组HBM3核心,显存容量提升到了192GB,显存带宽达到5.3TB/s,Infinity Fabric总线带宽达到896GB/s。

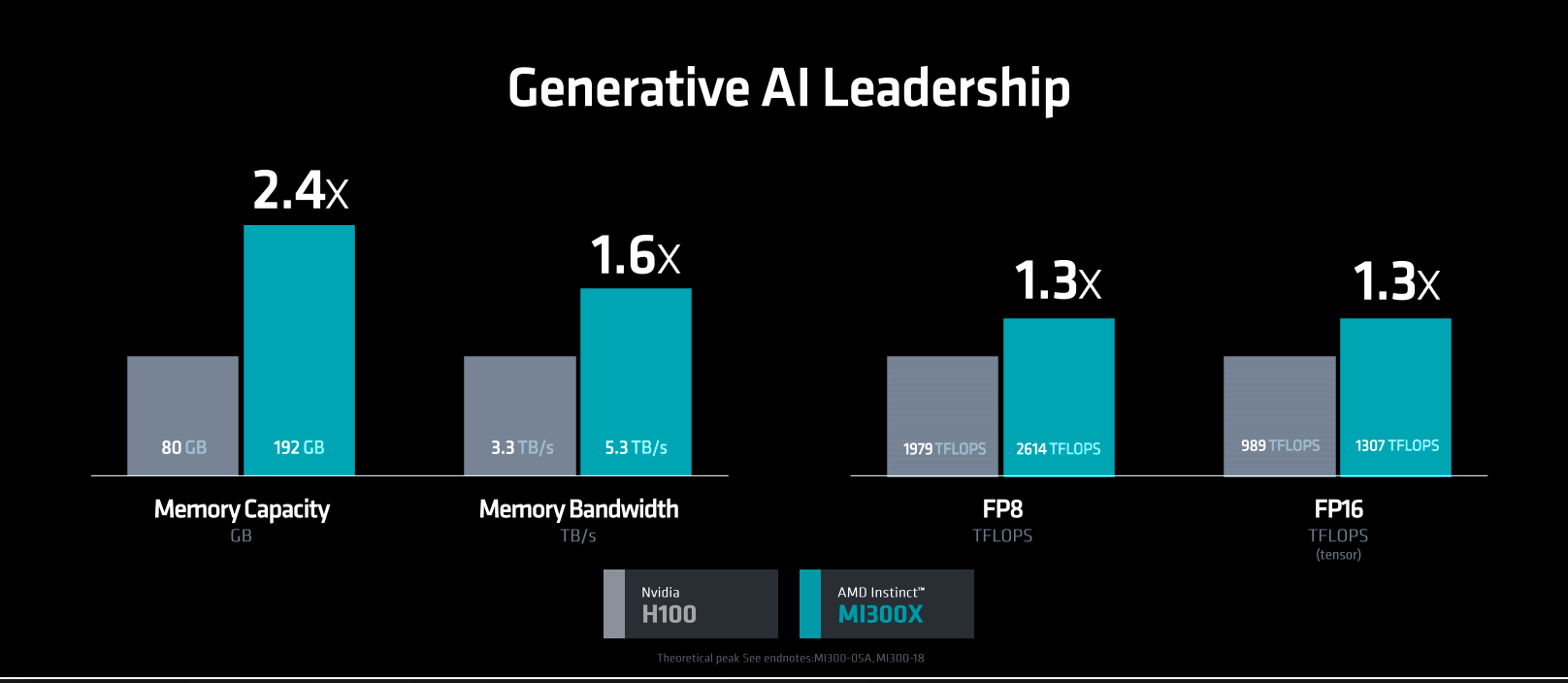

在针对生成式AI的性能上,同目前市面的竞品——英伟达的H100相比,MI300X在内存容量上提升2.4倍,内存带宽上实现1.6倍提升,8位和16位浮点计算方面也体现出优势。

在一些关键性的AI测试指标中,如Flash Attenton2以及Llama2(700亿参数),MI300X的表现均优于H100。

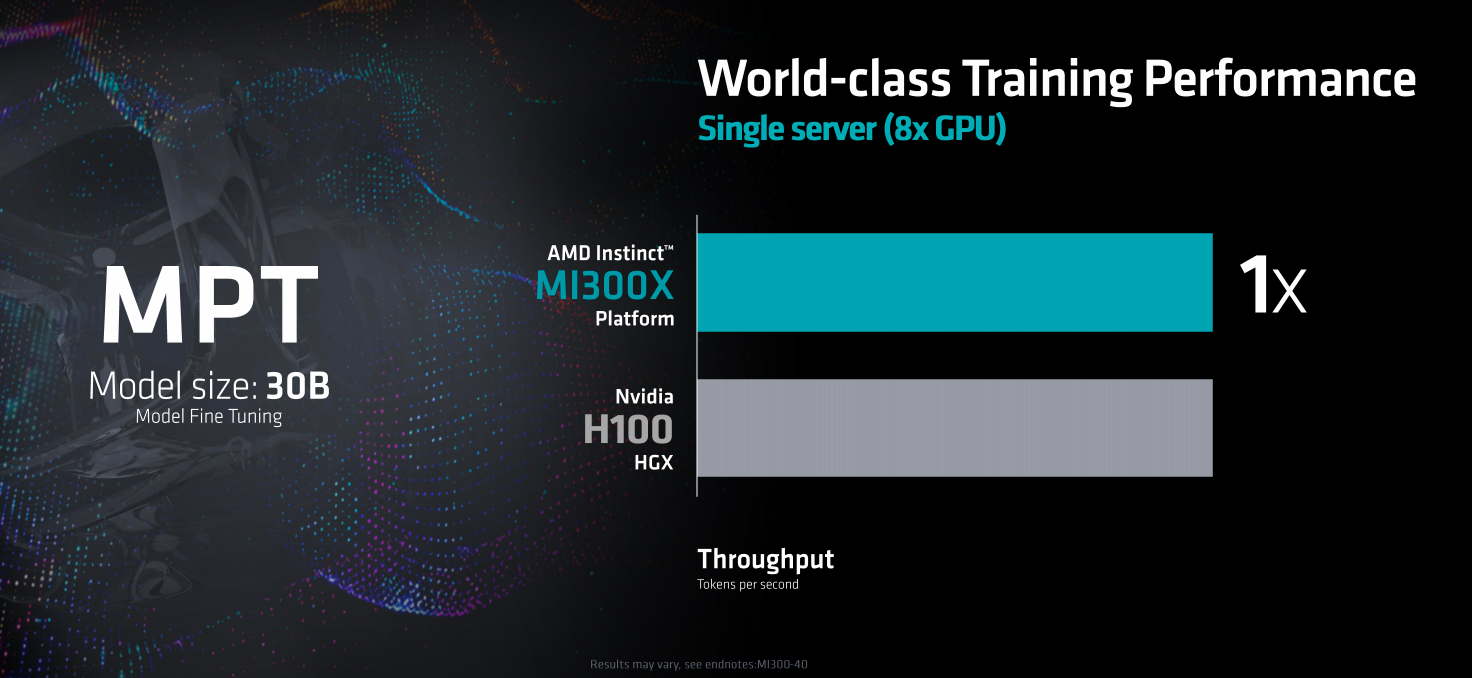

在由8个GPU组成的单台服务器的AI性能测试中,MI300X平台的推理性能表现更好。在训练方面,MI300平台的性能则与H100 HGX平台的性能相当。

目前,MI300X已经实现量产出货,并获得了多家OEM厂商和解决方案厂商的支持,包括HPE、戴尔、联想、超微、技嘉等。

一些分析机构的研判认为,MI300X性能强大,是对标英伟达高端加速卡的有力竞品。相较H100,MI300X在晶体管数量和显存容量上亦大幅领先,有望与英伟达在AI加速卡市场展开直接竞争。而随着下游应用端的高速发展,使得微软、谷歌、Meta等众多海外巨头争相增加算力储备,算力芯片需求高度旺盛之下,英伟达一家独大的市场格局或将迎来转变。

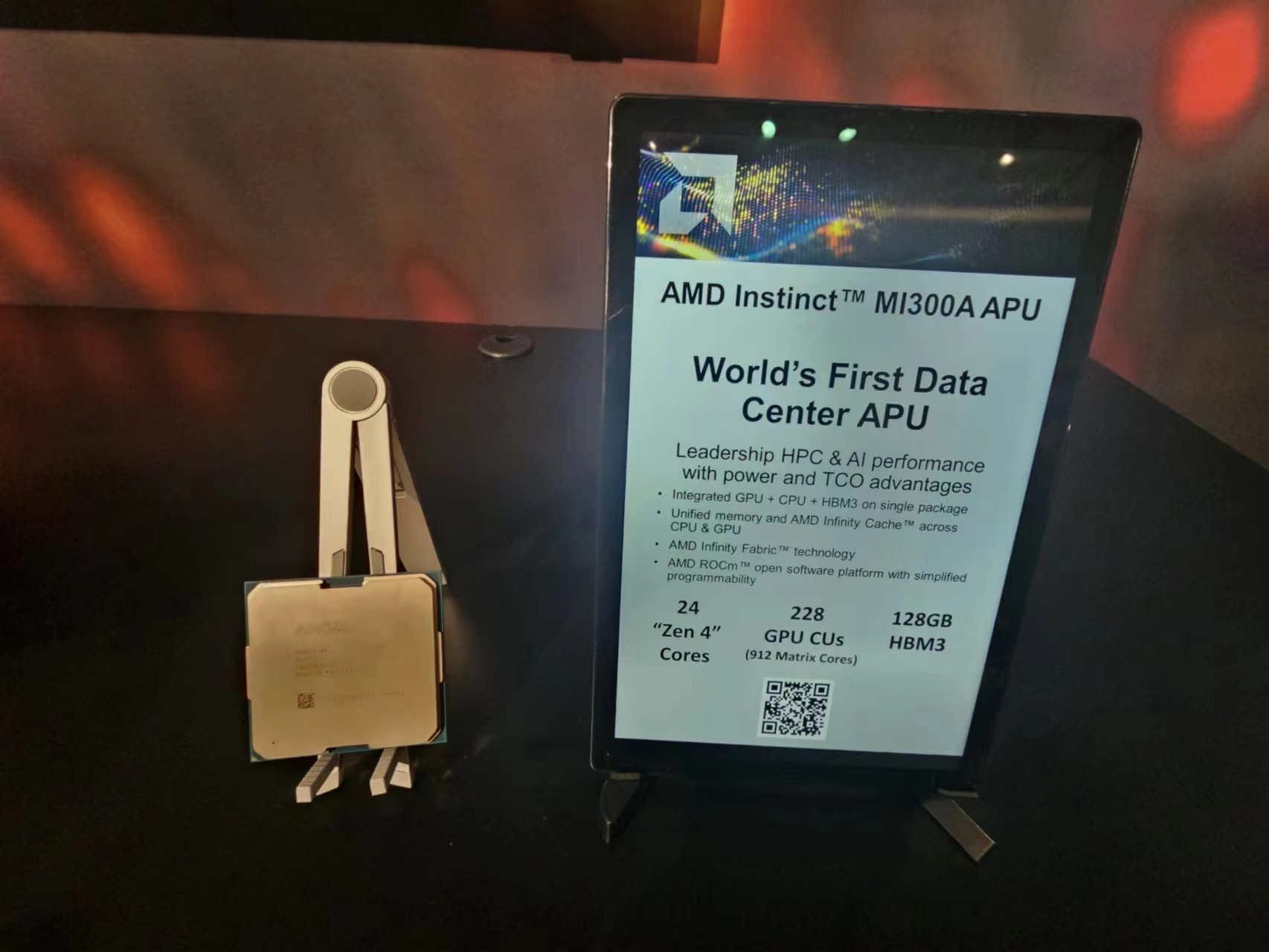

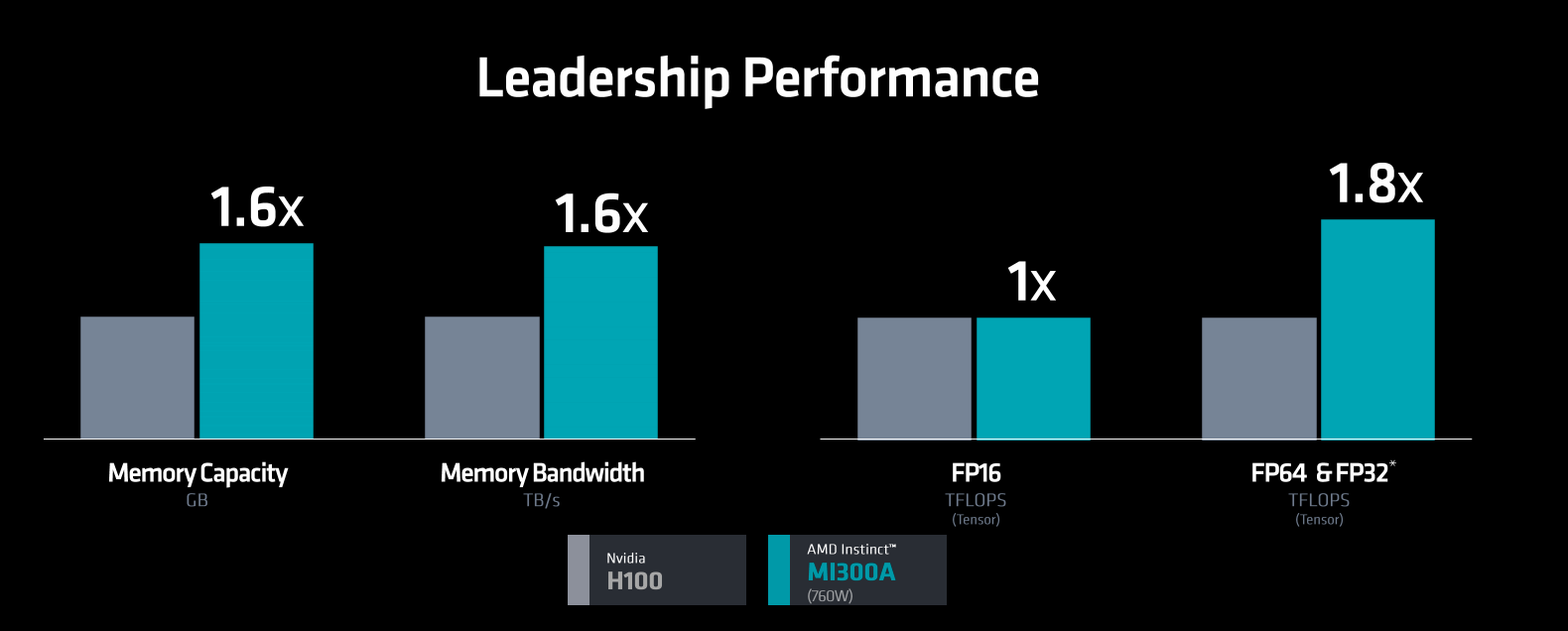

MI300A:全球首款面向AI/HPC的数据中心APU

MI300系列加速器产品包括MI300X以及MI300A。得益于AMD在CPU以及GPU方面多年来的深厚积累,在CPU、GPU融合计算方面具有独步天下的优势。

MI300A同时将Zen3 CPU、CDNA3 GPU整合在了一颗芯片之内,统一使用HBM3内存,使用第4代Infinity Fabric高速总线互联,从而实现结构的简化以及编程的便利性。

MI300A具有228个CDNA3架构的计算核心,24个Zen4架构的X86核心,4个IO DIe,8个HBM3,128GB显存,5.3TB峰值带宽,256MB的Infinity缓存,采用3.5D的封装形式。

据AMD方面介绍,统一架构下的APU的优势在与能够充分释放性能的潜力。统一的内存,同意的内存,共享的Infinity总线技术,动态的功耗分布以及编程上的便利等。

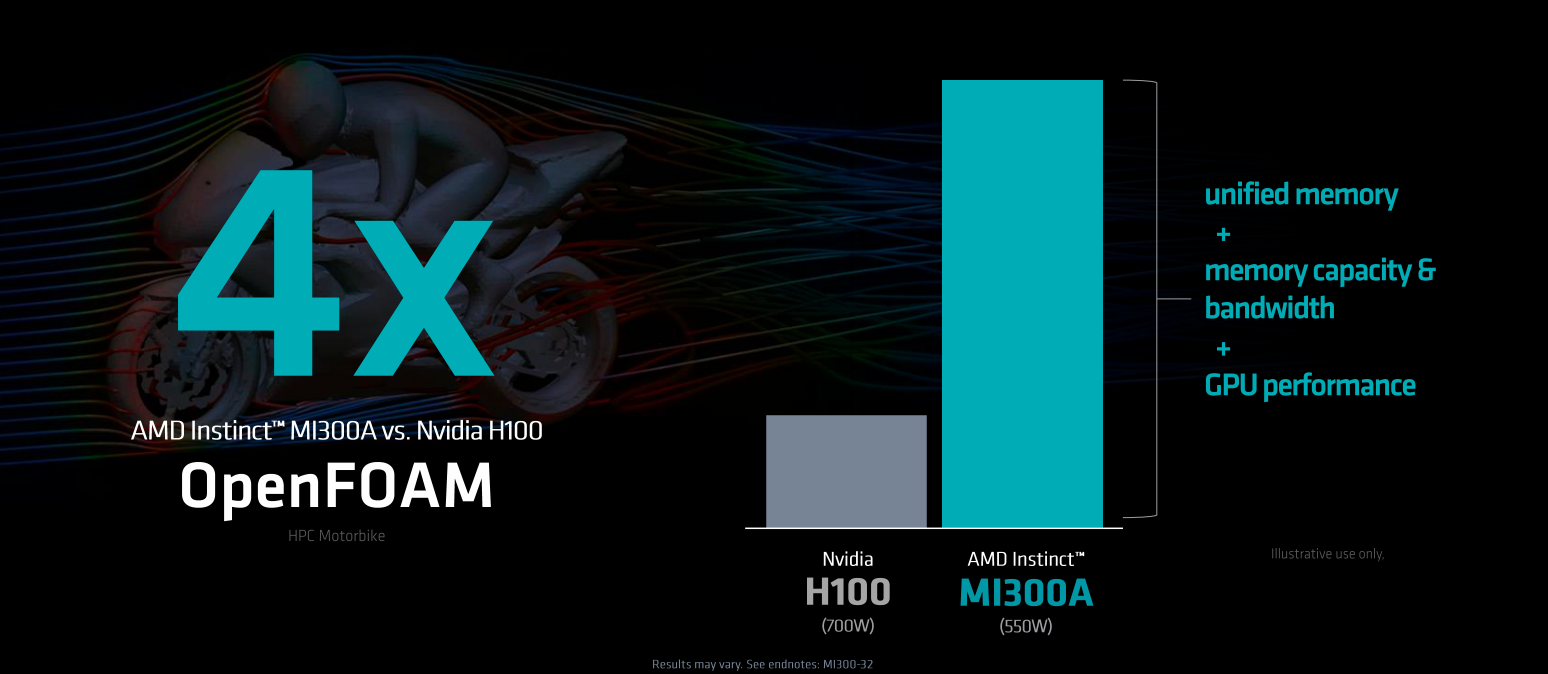

基于以上优势,在OpenFOAM的运行表现上,MI300A的性能表现要超过H100 4倍。每瓦特高性能峰值计算表现上是GH200的2倍。

在HPC等性能表现上也同H100持平或领先。目前,MI300A已经在美国劳伦斯利弗莫尔国家实验室的新一代超级计算机El Capitan中安装,在MI300A的加持下,El Capitan有望成为全球首个具备2 Exaflop(百亿亿次)双精度性能的超级计算机,预计交付后将成为世界上最快的超级计算机。

目前,MI300A正规模量产,MI300A的OEM和方案合作伙伴包括HPE、Eviden、技嘉、超微等。

2.AMD官宣锐龙8040系列处理器 引领AI PC时代

集微网报道 12月6日,AMD在美国加州城市圣何塞举行的“Advancing AI”活动上,宣布即将推出下一代锐龙8040系列处理器,为PC端注入更为强劲的AI能力,在端侧生成式AI火热的当下,引领AI PC的革命性创新。

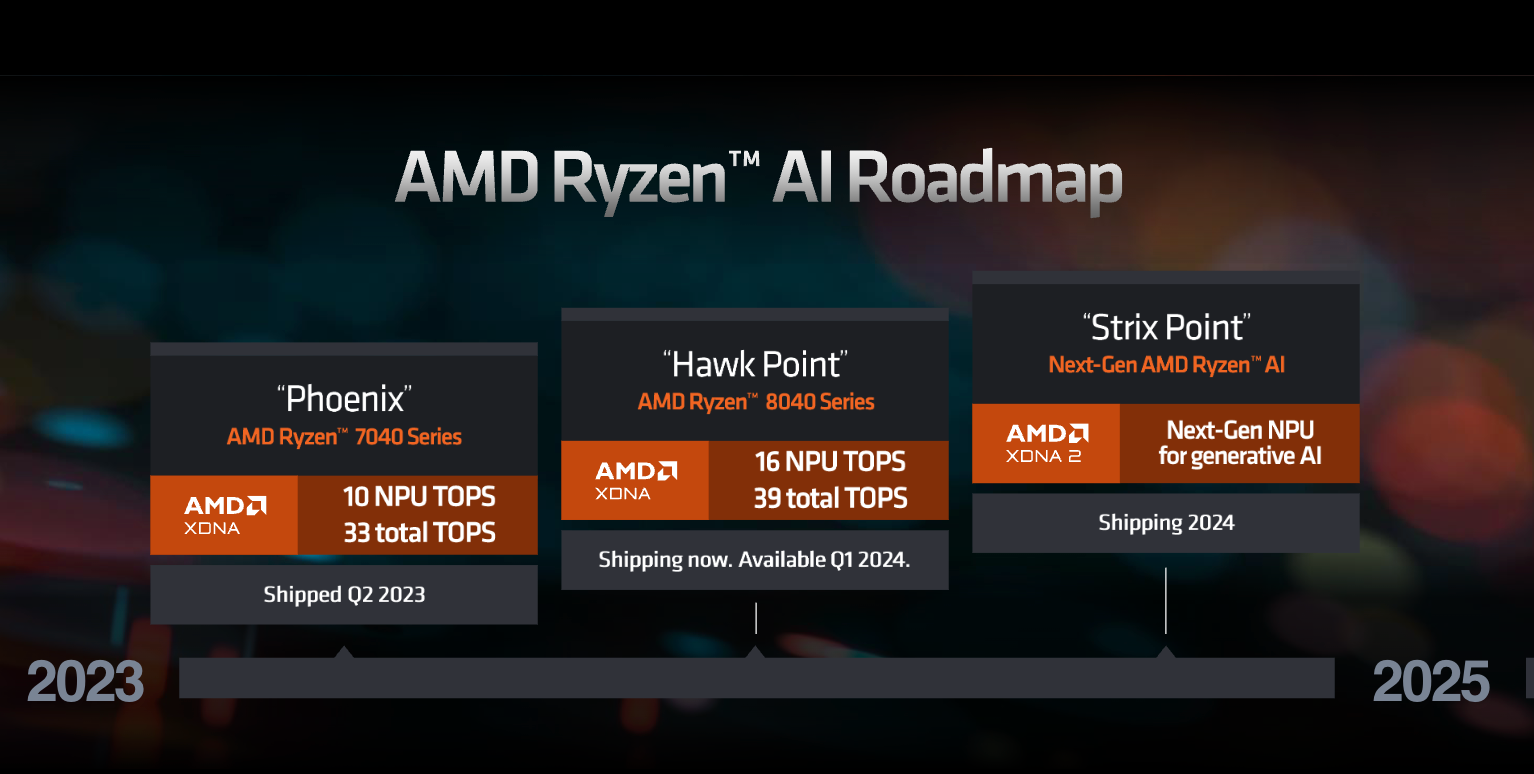

今年年初,AMD发布的锐龙7040系列处理器,便首次实现将独立的NPU AI处理单元引入X86处理器中,如今,更进一步,据介绍,锐龙8040系列基于Zen4 CPU架构、RDNA3 GPU架构、XDNA NPU架构,通过提升CPU、GPU和NPU的性能,进一步释放AI PC的潜力。

当下,受益于生成式AI浪潮以及PC市场的复苏,AI PC成为芯片厂商关注的焦点,无论是高通、联发科等移动芯片厂商,还是英伟达、AMD等传统PC芯片厂商。AI PC所具有的性能、安全、效率以及在使用体验等方面的优势,被普遍视为下一阶段个人电脑创新的方向。

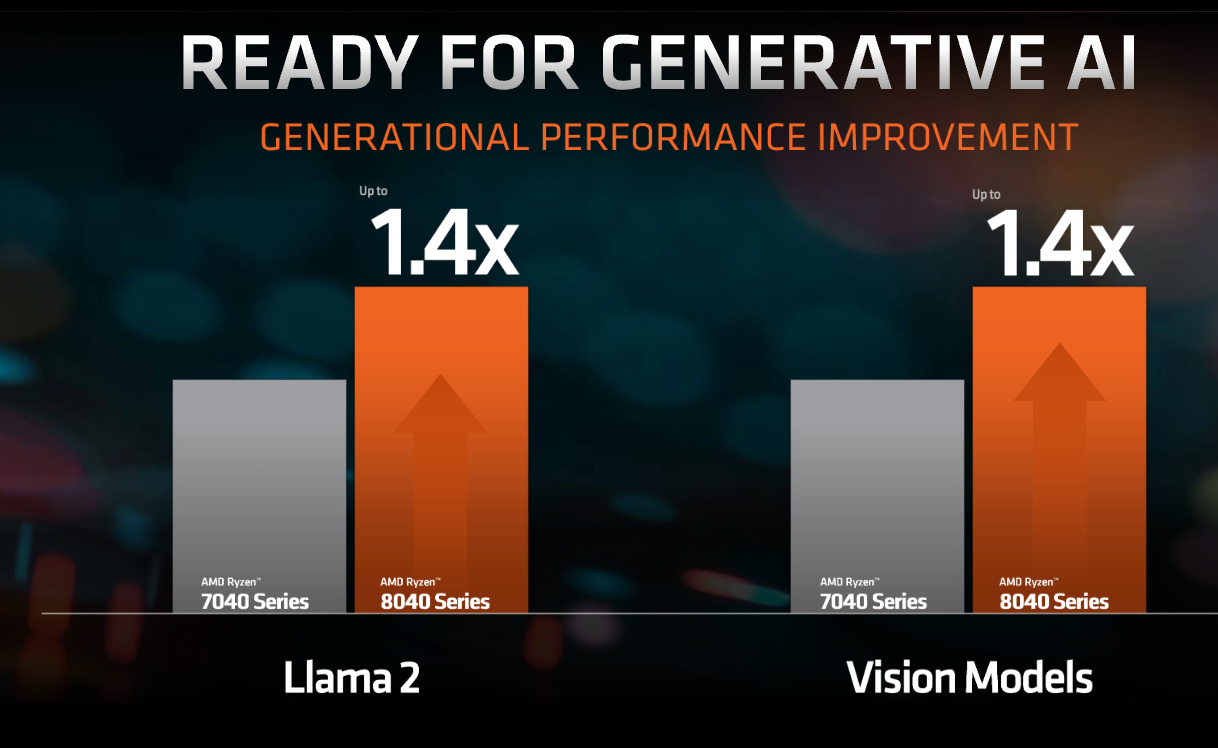

相较于上一代如锐龙7040系列产品,8040系列的NPU AI性能算力从10TOPS提升到16TOPS,整体算力从33TOPS增加到39TOPS。而在运行语言和视觉大模型方面,较上一代产品,也均能够实现40%性能的提升。

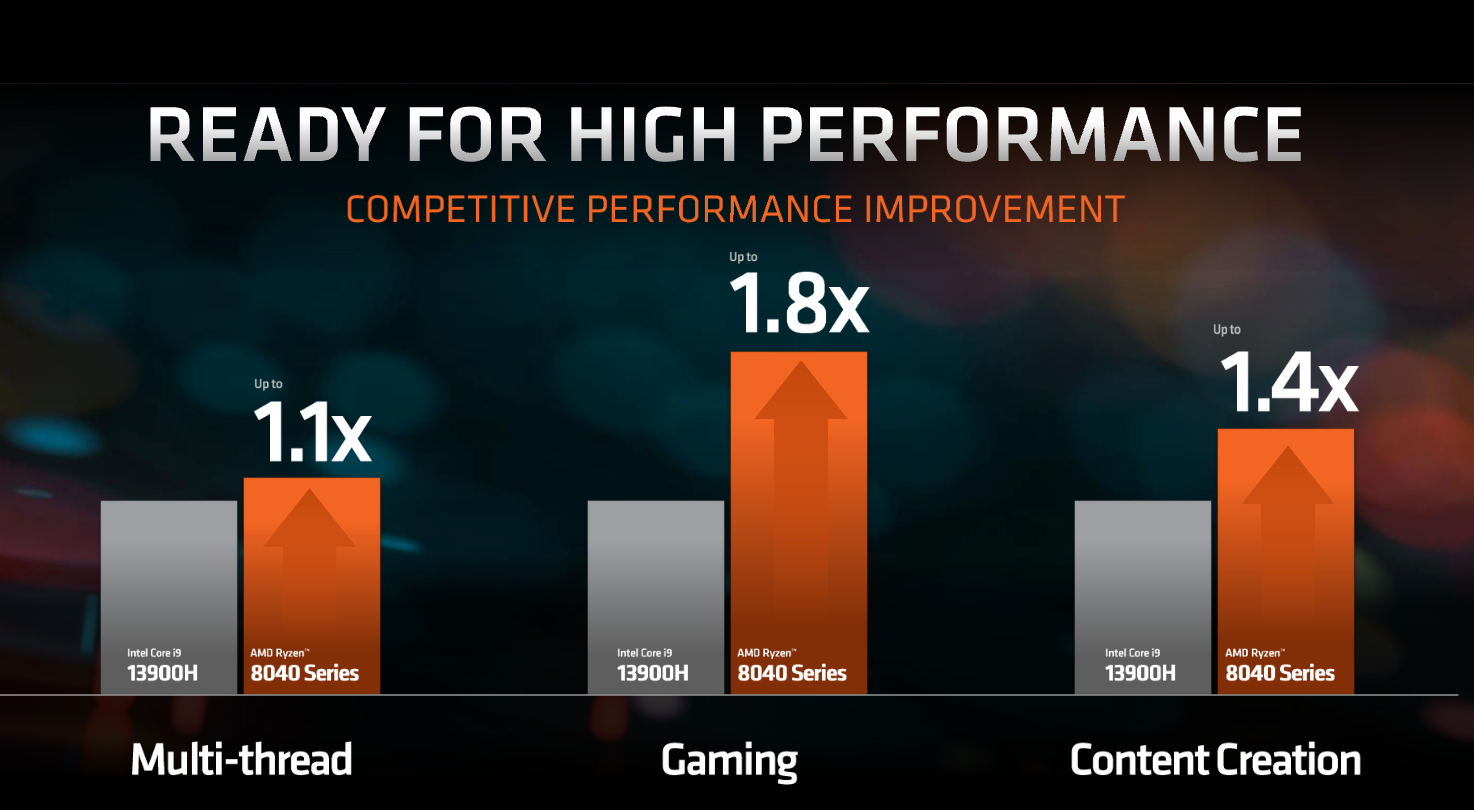

在高性能表现方面,相较于英特尔的i9-13900H,锐龙8040系列在多线程、游戏、内容创作方面均表现出优势。

代表锐龙8040系列的顶级型号锐龙9 8945HS与竞品酷睿i9-13900H相比,视频编辑性能领先最多64%、3D渲染性能领先最多37%,游戏性能领先最多77%。

目前,已经有50多款笔记本产品采用基于锐龙7040系列处理器的Ryzen AI,出货量数百万台,涵盖宏碁、华硕、戴尔、联想、惠普、雷蛇、小米等厂商品牌。

锐龙8040系列目前已经实现出货,预计搭载该处理器的相关PC产品将于明年Q1推向市场。而按照AMD的路线图,下一代AMD Ryzen AI产品将于明年出货,其NPU将会升级到XDNA2架构,在生成式AI性能方面将实现3倍的提升。

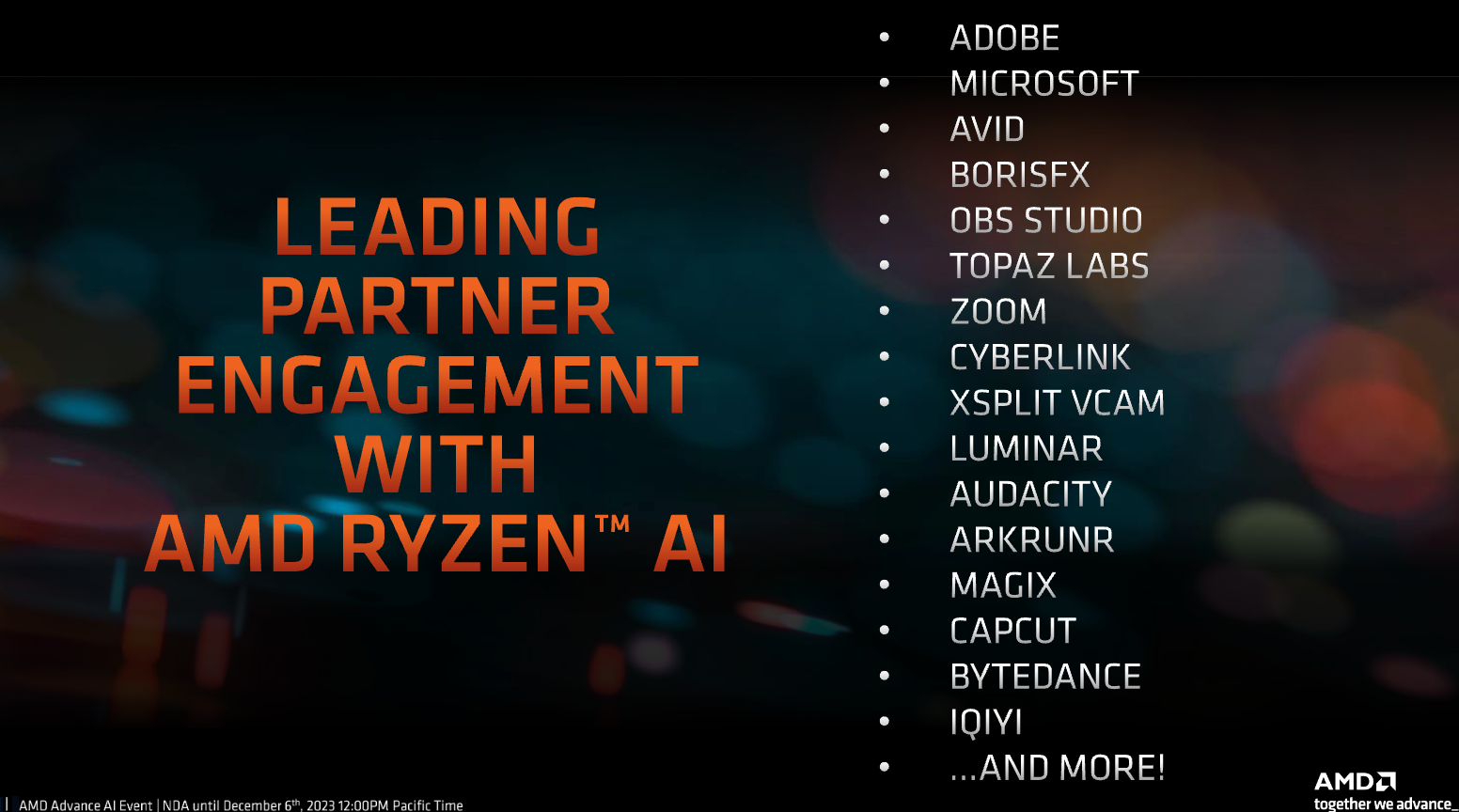

随着Ryzen 7040和8040的推出,将进一步加速AMD Ryzen AI处理器在市场的进一步渗透。接下来,AMD将着力提升Ryzen AI在软件方面的能力。目前Ryzen AI的应用也不断拓展,合作伙伴包括Adobe、微软、Zoom、Cyberlink、XSplit VCam、Luminar、Audacity、Arkrunr、Blackmagic Design、Capcut,以及字节跳动、爱奇艺等。

3.AI ASIC芯片带动封测与载板需求,台厂打入供应链

集微网消息,近期用于人工智能(AI)的特殊应用芯片(ASIC)带动半导体后段专业封测的需求,法人指出,包括日月光、京元电、南电、颖崴、精测等台厂,逐步切入AI ASIC芯片相关封测、载板和测试接口供应链。

美国投资机构报告分析称,中国台湾OSAT封测大厂纷纷切入英伟达、AMD的AI芯片供应链,以及科技公司定制的AI ASIC芯片供应链,2024年相关业绩可期。

其中在晶圆测试端,京元电在GPU芯片测试领域的市占率较高,成为美系AI芯片大厂的主要测试伙伴,预估最快明年起,该公司在AI ASIC芯片测试领域可逐步放量。预计2023年AI芯片占京元电整体业绩比重可提高至7%~8%,明年可提高至10%。

IC载板(基板)领域,南电通过中国台湾地区ASIC设计公司,开始供应ABF载板给美系云服务设备大厂,间接切入国际供应链。

测试接口端,颖崴董事长王嘉煌日前表示,2024年越来越多的厂商自行开发AI ASIC芯片,预计相关客户比重持续增加,将成为公司增长主力。颖崴也切入先进封装CoWoS测试接口,相关试验正在进行,预计明年MEMS探针卡等开始放量。

精测日前指出,2024年来自AI芯片测试接口解决方案,包括GPU、APU、ASIC等相关芯片,将贡献收益。

晶圆代工厂联电已经与华邦电、智原、日月光半导体及Cadence合作,布局晶圆对晶圆3D IC专案,加速3D封装产品生产。

日月光投控旗下的日月光半导体,积极布局扇出型FOCoS-Bridge封装技术,可整合多颗ASIC小芯片以及HBM存储芯片。

集微网了解到,目前多家海外科技大厂纷纷开发自研ASIC加速芯片,包括谷歌TPU、英特尔eASIC、特斯拉Dojo、亚马逊Trainium、微软Athena、Meta的MTIA架构等,带动ASIC设计、芯片封装和测试需求。此外,中国大陆的阿里平头哥、百度等,也在积极投入自研AI芯片开发。

此外,AMD还打造了Ryzen AI软件平台,全面支持TensorFlow、PyTorch、ONNX等主流AI模型,从而使开发者能够快速部署以及容易使用。

有分析指出,今年Q3季度,AMD的PC CPU同比环比出货都实现了超过40%的增长,呈现较好的发展态势,受益于新产品的量产出货,以及PC市场的逐渐回暖复苏,AI PC领域,AMD有望迎来较大的成长空间。

4.绝地反击GPT-4,谷歌推出最强大模型Gemini

集微网报道(文/陈兴华)被ChatGPT压制整整一年之后,谷歌展开了最强反击战。12月7日凌晨,谷歌CEO桑达尔·皮查伊(Sundar Pichai)和Deepmind CEO戴密斯·哈萨比斯(Demis Hassabis)在谷歌官网联名发文称,其最新大模型Gemini 1.0(双子星)版本正式上线。在他们看来,Gemini的发布仅仅是一个开始,更大的技术迭代、产品应用和生态构建宏图即将展开。

从测试数据来看,Gemini大模型在知识储备、专业能力和多模态等方面均超越GPT-4,而且部分核心能力首次超越了人类专家,这不仅对OpenAI构成了强有力的冲击和挑战,也标志着AI大模型浪潮进入一个新的阶段。但即使Gemini“效果惊人”,谷歌似乎并没有十足底气,包括没有公布Gemini顶尖大模型的性能数据,不免被质疑吹嘘过度和测试标准偏颇。

首超人类专家,多维领先GPT-4

作为筹备一年之久的GPT-4强力竞品,Gemini 1.0是目前谷歌能拿出手的功能最为强悍、适配最为灵活的大模型,分别包括Gemini Ultra、Gemini Pro和Gemini Nano三种不同套件。其中Ultra是谷歌最大、最强模型,适用于高度复杂的任务;Pro能力稍弱,是一个可扩展至多任务的模型;Nano则是一款适用于端侧设备运行的模型。

不过,谷歌方面并没有透露Gemini Ultra和Gemini Pro的具体参数大小,只是明确称规模最小的Gemini Nano的参数分别为18亿(Nano-1)和32.5亿(Nano-2)。但有传言称,Gemini Ultra的参数规模达到万亿级别,训练动用的算力是GPT-4的5倍以上。

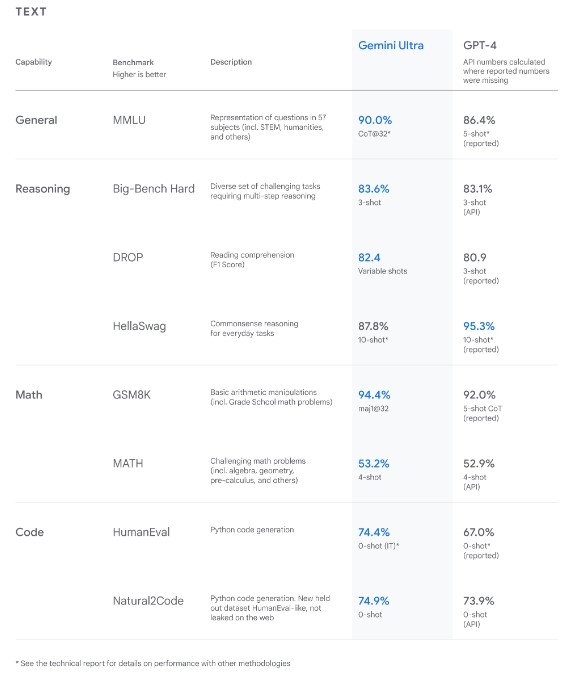

Gemini发布后,外界尤其关注其对GPT-4的挑战。谷歌DeepMind产品副总裁伊莱·柯林斯(Eli Collins)表示,团队一直在对Gemini进行严格的测试并评估其在各种任务中的性能。从自然图像、音频和视频理解到数学推理,在被大型语言模型(LLM)研究和开发中广泛使用的32项学术基准中,Gemini Ultra的性能有30项都超过了目前最先进的水平。

据MMLU(大规模多任务语言理解数据集)的测试结果,Gemini Ultra的得分率为90%,这款MMLU数据集包含数学、物理、历史、法律、医学和伦理等57个科目,专门用于测试大模型的知识储备和解决问题能力。作为对比,人类专家的得分率为89.8%,GPT4得分率为86.4%。这说明Gemini Ultra是第一个在MMLU测试中超过人类专家的模型。

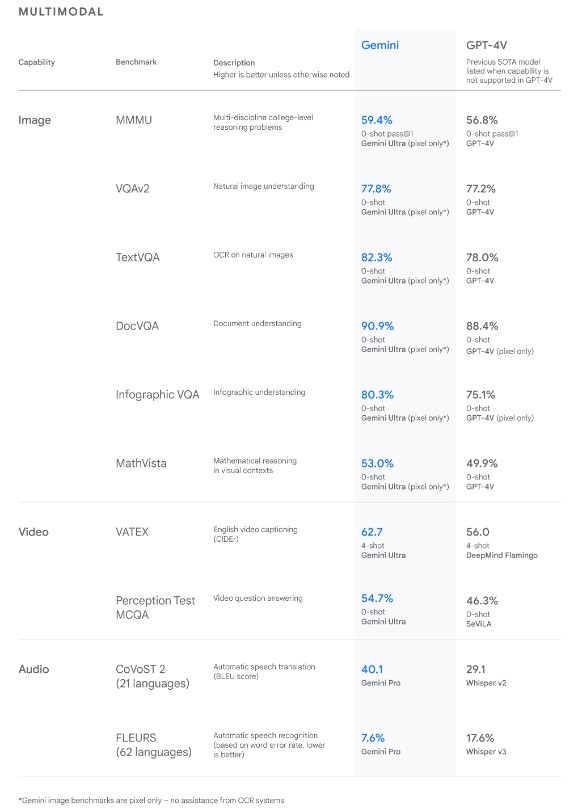

在多模态方面,Gemini Ultra在权威MMMU基准测试中也获得了59.4%的SOTA分数,高于GPT-4V的56.8%。这项基准测试是由跨不同领域的多模式任务组成,需要大模型进行深思熟虑的推理过程,而谷歌Gemini大模型多模态背后的技术原理也引发业界关注。对此,谷歌DeepMind首席科学家杰夫·迪恩(Jeff Dean)团队撰写了60页技术报告来阐述。

以往,多模态大模型是将纯文本、纯视觉和纯音频模型拼接在一起,例如OpenAI的GPT-4、DALL·E和Whisper等,但这并不是最优解。据戴密斯·哈萨比斯透露,Deepmind团队将Gemini设计为原生多模态,从一开始就在不同模态上进行预训练。然后,利用额外的多模态数据对其进行微调,以进一步提高其有效性。这有助于Gemini从最初阶段就能对输入的各种内容顺畅地进行理解和推理,并优于现有的多模态模型。

谷歌方面称,Gemini将通过其系列产品推向数十亿用户,其中谷歌聊天机器人Bard由Gemini Pro微调版本驱动,在170多个国家和地区提供英语服务并持续扩展,这是Bard自推出后的最大升级。而谷歌的Pixel 8 Pro将成为首款搭载Gemini Nano的智能手机,明年年初将推出Bard Advanced,提供Gemini Ultra模型的最佳性能。此外,值得注意的是,在Gemini亮相同时谷歌还推出了专为大模型设计的新一代TPU——Cloud TPU v5p。

“复仇者联盟”坐镇,竞争行业王座

一定程度上,谷歌发布Gemini多少让外界有些意外。在今年5月谷歌的开发者大会上,谷歌便高调对外宣布下一代大语言模型Gemini,按照原计划将在12月份对外正式发布。但近期传出谷歌将发布Gemini推迟至明年1月,谷歌方面给出的理由是“在某些非英语任务方面的表现不佳”,这曾引发了外界猜测谷歌在Gemini研发方面遇到了困难和挑战。

过去一年来,全世界的AI公司掀起“对标”GPT热潮,其中谷歌被视为当仁不让的最强大对手,但在与OpenAI的竞争中,回应却总步履蹒跚。或许是迫于外界预期压力以及加速追赶OpenAI,谷歌最终按原计划对外发布了Gemini。无论如何,Gemini的正式登场不仅形成了对OpenAI的有力反击,也意味着AI大模型浪潮进入到一个全新阶段。

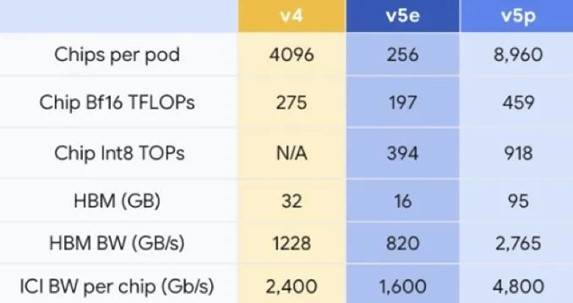

从如今公布的Gemini参数和使用效果来看,谷歌的“AI家底”自然不菲。例如在官方技术报告中,谷歌提到是使用TPUv5e和TPUv4对Gemini进行大规模训练,旨在将其打造成可靠、可扩展的训练模型和最高效的服务模型。在TPU上,Gemini的运行速度明显快于其早期规模较小、能力较弱的模型,如被曝参数规模为3400亿的PaLM-2。而最新的TPU v5p一旦纳入运营,将进一步减少谷歌训练Gemini大模型相关的时间投入等。

此外,为了强化技术班底,谷歌曾在今年4月直接把谷歌大脑(Google Brain)和DeepMind合并在一起,其中Google Brain曾经缔造了Tensorflow与Transformer架构,DeepMind则曾凭借AlphaGo掀起上一轮AI热潮、创造了AlphaFold预测蛋白质折叠。由于此前在行业竞争中失利,这一团队也被外界调侃是“AI复仇者联盟”。而正是基于汇合两个顶尖实验室力量的紧密攻关,Gemini才得以在多项指标上实现了对GPT-4的绝地反击。

前不久,OpenAI经历了全球瞩目的戏剧性“董事会内乱”,其CEO山姆·阿尔特曼(Sam Altman)突遭董事会罢免,但最终迅速回归。此后,OpenAI的未来发展增添许多新的不确定性,包括推出的GPT高级版无限期暂停等,这也给了谷歌等公司更多追赶的时间和机会。

目前来看,虽然OpenAI占有先机,通过ChatGPT获得了大量训练数据反馈,但谷歌也依然有着自身的技术和生态优势。据外媒此前报道称,Gemini至少在一个重要方面比GPT-4强,即除了来自网络的公共信息之外,Gemini还利用了来自谷歌旗下产品的大量专有数据。因此,在理解用户特定查询的意图时更准确,而且错误答案(即幻觉)也似乎更少。

在Gemini正式亮相后,业界不乏对其肯定和追捧,其中英伟达AI科学家范麟熙(Jim Fan)表示,迟到总比不做好,OpenAI王座终于有了强力竞争者。但对于Gemini“效果惊人”,也有分析称,谷歌有些吹嘘过度以及测试标准有失偏颇等,包括即便是通过Gemini Ultra对比,但很多项也都仅是略高于GPT-4和GPT-4V等模型。不过,艾伦人工智能研究所前CEO奥伦·埃齐奥尼(Oren Etzioni)则称,“没有理由怀疑Gemini在这些基准上比GPT-4更好,但没准GPT-5会比Gemini做得更好。”

5.联电11月营收同比下降16.7%,Q4利用率预计为61%~63%

集微网消息,纯晶圆代工厂联电(UMC)公布2023年11月营收环比下降2.1%,同比下降16.7%,至187.9亿元新台币(5.964亿美元)。

联电2023年前11个月累计营收为2055.5亿元新台币,同比下降20.3%。

联电此前预测第四季度晶圆出货量环比下降5%,平均售价增长持平。第四季度晶圆厂利用率平均为61%~63%,低于第三季度的67%,这可能使公司的毛利率从上一季度的35.9%降至31%~33%。

联电公司联席总裁Jason Wang此前表示,计算机和通信领域的短期需求正在逐渐恢复,而汽车市场的状况仍然充满挑战,客户继续采取谨慎和保守的态度来管理库存水平。

联电预计,南科12A六期晶圆厂于2024年投产后,将大幅提升22/28nm的营收贡献,对公司营运带来显著提振。此外,联电将加快推出22nm相关应用产品,以拓宽其特殊工艺产品范围。

联电的28nm和22nm工艺制造销售额占晶圆总收入的比例在2023年第三季度攀升至32%,高于上一季度的29%和去年同期的25%,而40nm芯片销售额占晶圆总收入的13%。

6.AMD预计今年AI芯片市场规模450亿美元,明年供应大增

集微网消息,AMD于12月6日在加利福尼亚州举行发布会,正式推出MI300X生成式人工处理器等产品。AMD CEO苏姿丰表示,此次发布会是AMD 50年历史中最重要的一次,将在炙手可热的人工智能(AI)市场与英伟达竞争。AMD预计2023年人工智能AI处理器市场规模约为450亿美元,高于今年6月的预测。

苏姿丰认为,建设可以与人类智能相媲美的人工智能系统,被认为是计算机领域的圣杯,现在已经可以期待。但是这项技术的应用才刚刚开始,评估AI对生产力、经济等方面的影响还需要时间。

苏姿丰表示,明年AMD的AI芯片供应量将“相当可观”,远远超过20亿美元的价值。预计未来AI芯片需求将快速增长,市场规模到2027年将达到约4000亿美元。

分析师预估,如果把Alphabet旗下谷歌、微软等公司制造的定制芯片考虑在内,英伟达已占据了大约80%的人工智能芯片市场。英伟达没有对其AI产品的收入进行细分,但该公司的数据中心业务营收占比已非常大,今年以来收入已达291.2亿美元。

登录

登录