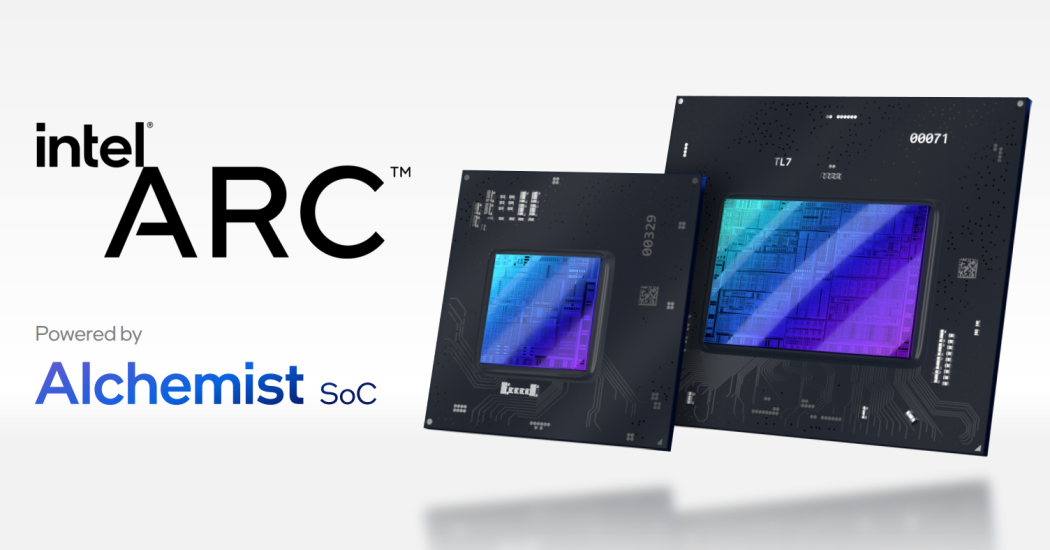

在刚刚结束的2021年架构日上,Intel公布了全新的独立显卡架构Xe HPG,基于该架构的首批GPU将采用台积电N6工艺,于2022年第一季度上市。这是Intel从1998年发布i740以来,二十多之后再次踏入独立GPU市场。

由于Intel的加入,独立GPU的市场将再次变成“三国杀”的局面,从图形图像到AI和高性能计算,技术竞争和市场争夺将全面升级。

从专用到通用

GPU市场行情大好。根据市场研究公司Jon Peddie Research的报告,2021年第一季全球 GPU出货量达1.19 亿颗,同比增长38.78%,环比下降3%。

虽然Intel在整体GPU出货上占据了68%的市场份额,但是在独立GPU方面,英伟达则以81%的份额占据绝对领先,而AMD以19%的占有率排名第二。据JPR的分析师预测,独立GPU的出货量还将继续提升,到2025年将占整体GPU市场的26%。

无论是云端、边缘侧还是终端,各种电子系统都需要高性能的图像处理能力,GPU的发展因此进入加速阶段。独立GPU因为用途广泛,更是成为了大芯片中的佼佼者,架构和工艺都已达芯片业的顶峰。

英伟达在2020年发布的面向消费市场的旗舰级GeForce RTX 30系列GPU,采用了三星8nm工艺,其中的RTX3080和RTX3090,所包含的晶体管数目已经达到了280亿个。与之对应,AMD的RX 6000系列,采用了台积电的7nm工艺,晶体管数目也达到了268亿个。

顶尖的工艺和庞大的晶体管数目对应了越来越复杂的芯片架构。以目前最新的英伟达安培(Ampere)架构为例,其运算部份就包括了流处理器(Stream Processor,SP)、纹理单元(Texture mapping unit, TMU)、张量单元(Tensor Core)、光线追踪单元(RT Cores)、光栅化处理单元(ROPs)。

其中,在游戏中应用越来越多的光线追踪技术由光追单元来负责,而将GPU带入AI领域的则是张量单元,可用于实时深度学习、大型矩阵运算和深度学习超级采样(DLSS)。这两个单元的引入也将GPU的性能和作用完全提升,从图形处理器升级成计算处理器。

为了追求性能的极致,独立GPU之间的竞争因此就演化了成了架构之间的比拼。英伟达在2020年推出了安培架构,AMD则回应了RDNA 2架构,使得其RX 6000在性能上可以与RTX 30一较高下。

有人将GPU架构的升级趋势概括为“更多”、“更专”、“更智能”。晶体管数量和运算单元的增加是为多,其中包括流处理器单元、纹理单元、光栅单元等数量上升。“更专”是指除了常规的计算单元,GPU还会增加新的运算单元。“更智能”是指GPU的AI运算能力上升。

这次Intel加入战局也是有备而来,Xe架构经过多年打磨而出,不但具备了时下最流行的各种元素,还使用了台积电的6纳米工艺,完全有实力与英伟达和AMD一较高下。

不过,有业内人士指出,Intel还是一个基因属于CPU的公司,而在GPU上的投入需要配合CPU的成长,因此处理好CPU和GPU之间的发展冲突将是一个很大的挑战。

争夺数据中心和更广阔天地

2012年,多伦多大学Alex Krizhevsky创建了能够从100万样本中自动学习识别图像的深度神经网络。仅在两块NVIDIA GTX580 GPU上训练数天,“Alex Net”就赢得了当年的 Image Net竞赛,击败了磨练几十年的所有人类专家算法。认识深度学习的强大后,斯坦福的 Andrew Ng与NVIDIA研究室合作开发了一种使用大规模GPU计算系统训练网络的方法。深度神经网络技术从此迅速发展,也一举奠定了GPU在AI领域的地位。

GPU提供了多个并行计算的基础结构,并且核心数较多,可以进行海量数据的并行计算,还拥有更高的访存速度和很高的浮点运算能力。这一切都使得GPU完美契合了AI计算的需求。

当前,GPU是AI“训练”阶段较为适合的芯片。GPU在AI时代的云端训练芯片中占据较大的份额,达到64.%。虽然后期由于FPGA以及ASIC技术的突破,GPU的市场份额有所下降, 但是仍然是云端训练市场份额最大的芯片,2019年-2021年年复合增长率达到40%。

这一切的起点就是GPGPU的应用。用于通用计算的GPU被称为GPGPU,可以与CPU协同工作,将一些大计算量的负载承接过来,以加速应用程序。

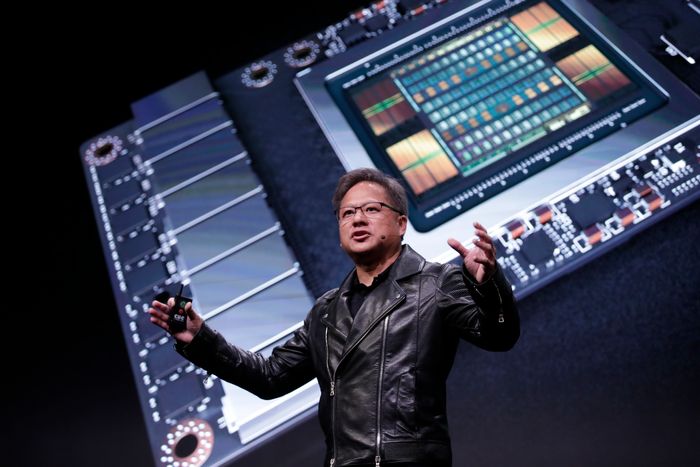

GPGPU的概念始于学界,真正让其发扬光大的还是英伟达。2006年,英伟达推出了Tesla架构,把GPU中的矢量计算单元拆成了多个标量计算渲染单元,使其更适合通用计算。2007年,英伟达又推出了CUDA,专为GPU设计的并行计算平台和编程模型。通过CUDA可以大大降低用GPU做通用计算的难度,因此大大降低了GPGPU应用的门槛。

当CUDA与深度学习相结合,更是释放了GPU的巨大潜力,也让AI从实验室走入了业界。同时,GPU也稳固了自己在数据中心的地位。

凭借GPU在数据中心的表现,英伟达的业绩也一路走高。在2022年Q1财季,其数据中心业务营收为20.5亿美元,创下公司历史上的新纪录,与上年同期相比增长79%,与上一季度相比增长8%,占总营收的比重已达36%。

在此领域发力较晚的AMD现在也开始奋起直追。根据 AMD 首席执行官 Lisa Su 的说法,该公司第二季度数据中心 GPU 的销售收入“同比增长了一倍多”。 Lisa Su将该细分市场的出色表现归功于该公司 Instinct 加速器部署的增加,其中还包括其基于 CDNA 2 架构的最新数据中心显卡的首次出货。

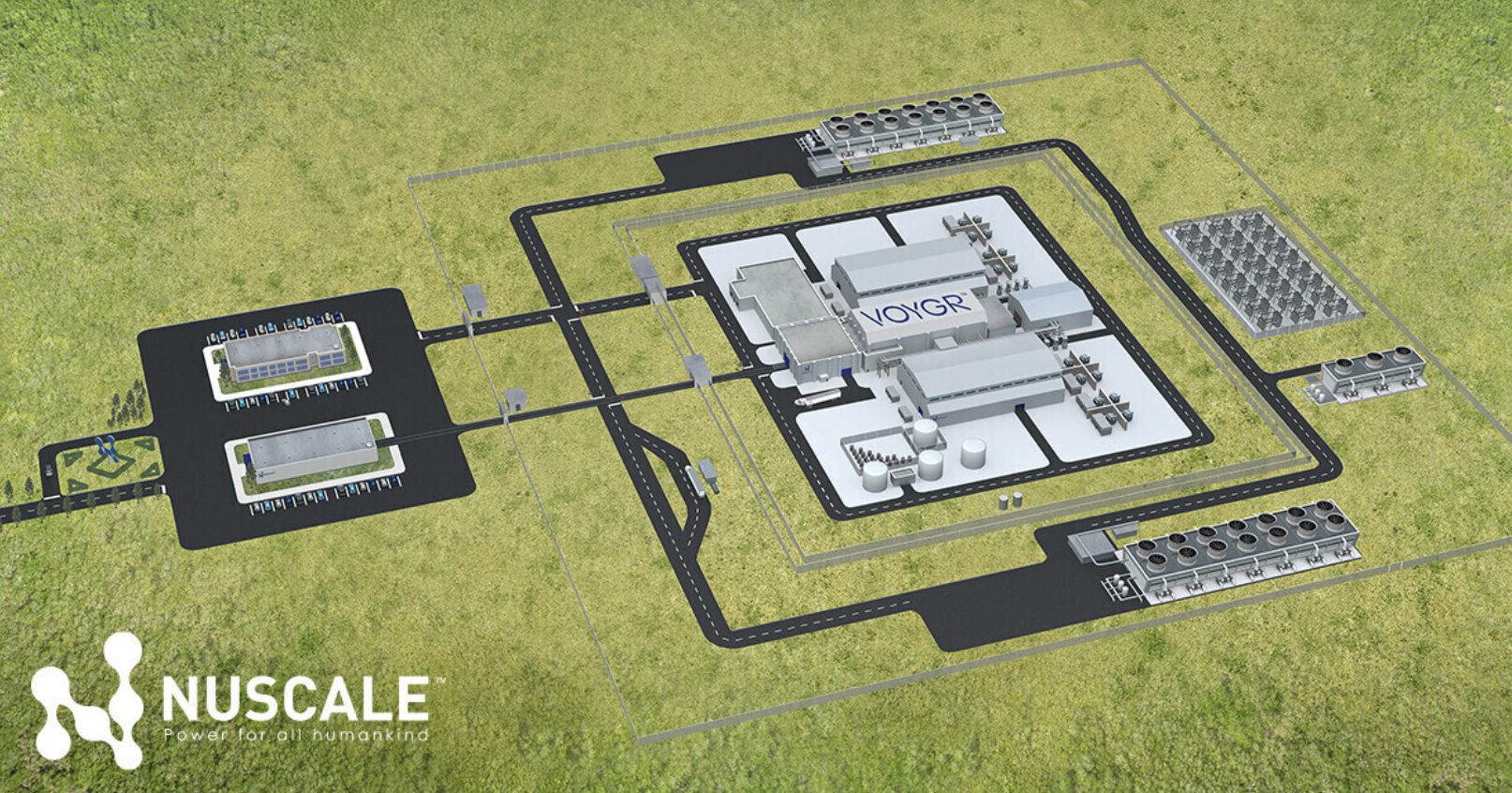

现在,终于轮到Intel出手了。最新的面向数据中心的GPU Ponte Vecchio重磅出炉,拥有1000亿颗晶体管的SoC也创下了Intel之最。

Ponte Vecchio 基于 Xe-HPC 微架构,由多个复杂的设计组成,这些设计以单元形式呈现,然后通过嵌入式多芯片互连桥接(EMIB)单元进行组装,实现单元之间的低功耗、高速连接。这些设计均被集成于 Foveros 封装中,为提高功率和互连密度形成有源芯片的 3D 堆叠。

“在ASIC和FPGA都在与GPU进行竞争的时刻,Intel选择了GPU,说明GPU可能还是通用AI的最好选择。”行业专家刘明(化名)这样评论道。

这颗巨大的芯片也可以被看做是对英伟达推出数据中心CPU的反击,双方至此都形成了CPU+GPU的布局。

同时,英特尔还在发展其oneAPI计划,使其成为Nvidia CUDA的强大竞争对手,因为它的范围不仅限于GPU,而且涵盖CPU和所有处理器。

尽管独立GPU不能完全取代CPU,但是其已经成为数据中心中非常关键的一环。当三大芯片厂商都汇聚于此时,GPU还会有更多精彩的故事。(校对/艾禾)

登录

登录